Tesla Dojo 超级计算机深度技术介绍与全面分析(下)

本文在《Tesla Dojo 超级计算机深度技术介绍与全面分析(上)》的基础上继续分析Tesla Dojo 超级计算机。

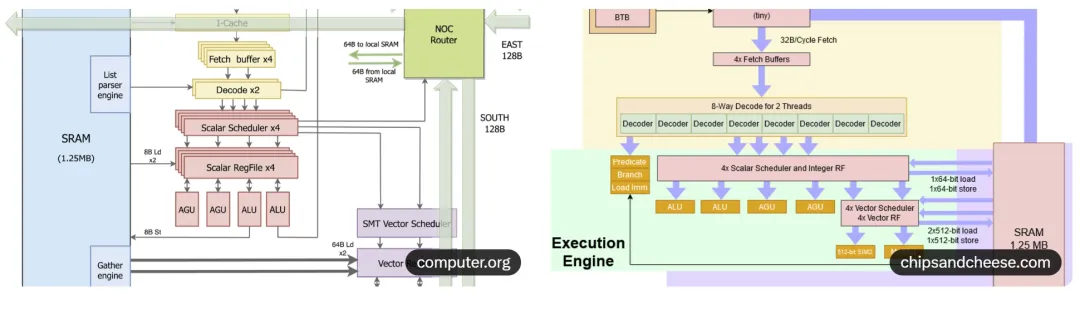

2.2 自定义指令集 TISA 与数据通路

D1 使用 Tesla Instruction Set Architecture(TISA),非标准 ISA。指令编码高度压缩,支持零开销循环、条件执行和软件流水。编译器从 PyTorch/XLA 前端生成 TISA 二进制。数据通路亮点:

-

向量寄存器文件 128×1024-bit。

-

矩阵单元采用 2D systolic array,输入站(Input Station)缓存激活,权重站(Weight Station)缓存权重,输出站累加结果。

-

支持配置精度:BF16(标准)、CFP8(Configurable Fixed Point 8-bit,Tesla 自定义,动态调整指数范围,视频训练中损失极小但带宽减半)。

CFP8 格式详解:8-bit 浮点,1 符号位 + 4 指数位 + 3 尾数位(可配置),相比 FP8 更灵活,在视频数据(动态范围有限)中精度损失 <0.1%,但计算密度提升 4 倍。

以下是 CFP8 格式与 systolic array 图:

2.3 I/O 与片上网络

D1 边缘集成 40 组高速 SerDes,每组 112 Gbps,总 off-chip 带宽 4.5 TB/s(四方向各 1.125 TB/s)。片上网络为 2D mesh + torus,带宽密度 >10 TB/s/mm。单芯片峰值性能:

-

BF16:362 TFLOPS

-

CFP8(密集):~1 PFLOPS(Tesla 内部评测)

-

功耗:400-650W(视负载)

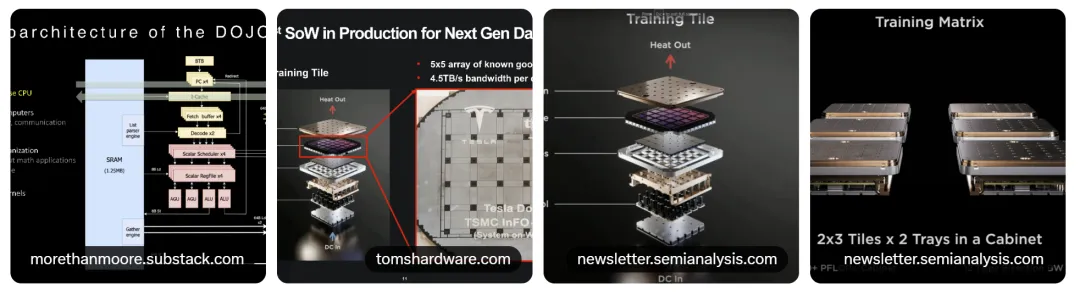

3.Training Tile:晶圆级集成(System on Wafer)革命性设计

Dojo 最大创新是 Training Tile:直接在 300mm 晶圆上集成 25 个 D1 芯片(5×5 阵列),不切割封装,使用 Through-Silicon Via(TSV)垂直互联 + 重新布线层(RDL)形成单一巨型“芯片”。

3.1技术细节

-

面积:约 762 mm × 762 mm(整晶圆)。

-

计算核心:8850 个训练节点(354×25)。

-

SRAM 总量:11 GB(442 MB × 25)。

-

内部带宽:TSV 密度 >100 万根/芯片间,单向带宽 >50 TB/s,芯片间延迟 <10 ns。

-

边缘 I/O:每个方向 4.5 TB/s(继承 D1),总 off-tile 18 TB/s。

-

电源交付:创新集成 Voltage Regulator Module(VRM)直接在晶圆背面,输入 48-52V 电网电压,降压至 0.8V 核心电压,效率 >95%,避免传统 PCB 损耗。

-

冷却:双相浸没式或微通道液冷,直接接触硅背面,热流密度支持 1 kW/cm²。

这种 wafer-scale 设计解决了传统多芯片模块(MCM)的封装良率、信号完整性和成本问题。Tesla 声称同等计算密度下成本仅 NVIDIA 的 1/5-1/10。

以下是 Training Tile 高清实物与结构图:

3.2 TSV 互联与良率挑战

TSV 直径 ~5μm,间距 ~20μm,垂直贯穿硅片实现芯片间全互联。Tesla 与 TSMC 合作开发专用工艺,良率从早期 <30% 提升至 2024 年 >70%。缺陷芯片可通过冗余路由绕过。

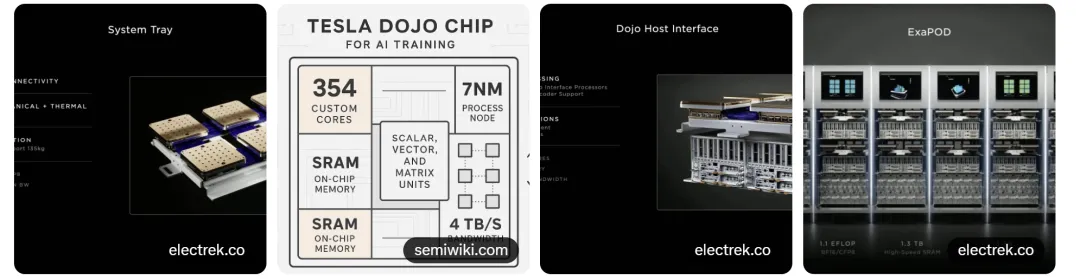

4.系统级架构:从 Tile 到 Exapod

4.1 System Tray

单个 Tray 集成 6-8 个 Training Tile + Dojo Interface Processor(DIP,基于 x86 或 ARM,处理主机通信、存储接口)。Tray 尺寸约 1m × 1m,功耗 100-120 kW。

4.2 Cabinet 与高维网络

多个 Tray 垂直堆叠成 Cabinet,采用 5D Torus 网络拓扑(Tesla 专利):每节点 10 个方向链路(每方向 9 TB/s),总带宽 >1 EB/s(Exapod 级)。无阻塞、低延迟,支持 AllReduce 等集体通信原语硬件加速。

4.3 Exapod 完整系统

一个 Exapod 包含 120 个 Training Tile(3000 个 D1,超过 100 万训练节点):

-

峰值性能:1.1 ExaFLOPS(BF16/CFP8)

-

总 SRAM:>1.3 TB

-

总功耗:~1.5 MW

-

体积:单个机柜集群

以下是系统级架构与机柜照片:

5.电源交付与热管理技术细节

5.1 集成 VRM 电源系统

传统超级计算机电源损耗占 20-30%,Dojo 在晶圆背面集成 DC-DC 转换器,直接 52V 输入 → 0.8V 输出,效率 97%,热损极低。

5.2先进冷却方案

采用微通道冷板 + 两相冷却液(可能为 Novec 或类似),直接嵌入晶圆背面,热传递系数 >100 kW/m²K。Buffalo 数据中心曾因 Dojo 上电导致电网跳闸(2022 年),反映其极端功率密度。

以下展示了电源与冷却相关图表:

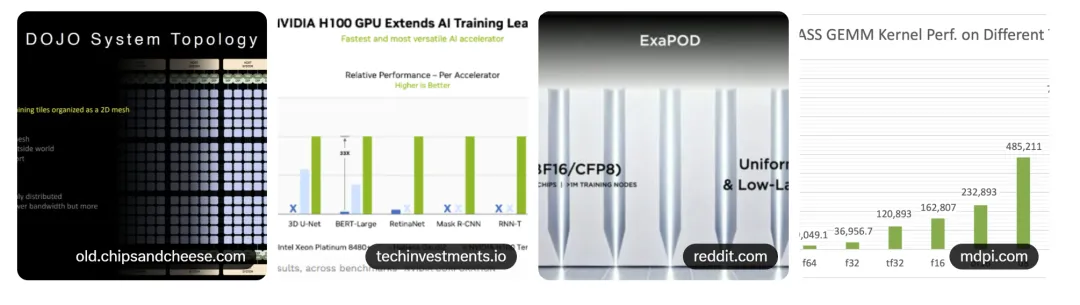

6.性能实测与 NVIDIA 深度对比

理论上,单个 Training Tile(9 ExaFLOPS CFP8)在视频训练中可超 8 节点 DGX A100 系统 4-6 倍。实测(2024 年数据):

-

Dojo 1 Exapod ≈ 8000-12000 H100(MLPerf 类似负载)

-

能效:Dojo 约 2-3× NVIDIA(同等性能功耗更低)

-

成本:Tesla 内部估算 <1/5

但软件瓶颈明显:缺乏 CUDA 生态,编译器优化空间大。

7.软件栈与训练流水线集成

Dojo 软件栈包括:

-

前端:PyTorch + XLA 编译器

-

中间层:Tesla 自定义 Graph IR

-

后端:TISA 代码生成 + 运行时调度

-

集体通信:硬件加速 AllReduce,效率 >95%

在 Tesla “数据引擎”中,Dojo 处理从车辆采集 → 自动标注 → 端到端训练 → 模型压缩部署的全流程。

8.挑战、风险与未来展望

主要挑战:

-

晶圆级良率与制造难度(大芯片缺陷指数增长)

-

软件生态落后

-

通用性差(仅视频训练高效)

-

早期部署电力基础设施压力

未来 Dojo 3(基于 AI5,预计 3-5nm 工艺,单芯片 >10 PFLOPS)将解决这些问题。Space Dojo 构想若实现,将开创太空计算先河。

Dojo 代表 AI 硬件极致定制化方向,其 wafer-scale、集成电源冷却、自定义格式等创新已深刻影响行业。即使短期依赖 NVIDIA,长期看 Dojo 是 Tesla AI 霸权的核心基石。

评论